|

電子情報通信学会 - IEICE会誌 試し読みサイト

© Copyright IEICE. All rights reserved.

|

|

電子情報通信学会 - IEICE会誌 試し読みサイト

© Copyright IEICE. All rights reserved.

|

スマートインフォメディアシステム研究専門委員会

感性を考慮した画像生成

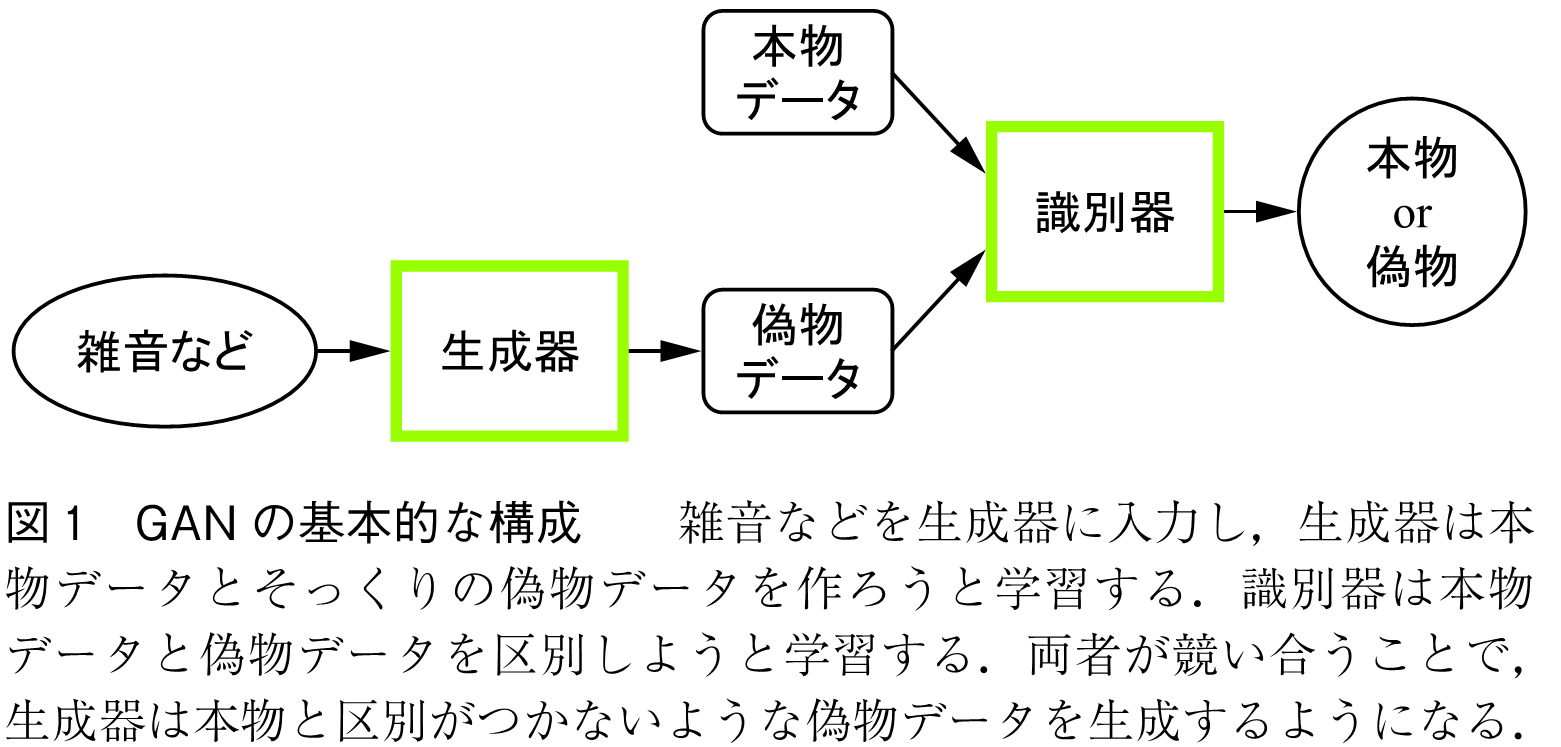

人工知能(AI)を使って画像を生成する際,画像に対する人の感性を考慮する仕組みを取り入れ,人の好みや理想を反映した画像を自動的に生成することができる.これが感性を考慮した画像生成である.画像は数理的にモデル化することが難しく,任意の画像を効果的に生成することは長い間の課題であったが,21世紀に入ってからのAI技術により,それが可能となった.特に,2010年代,Hintonらが階層形ニューラルネットワークの多層化,すなわち,深層学習を発表し,それまで実現が困難だった高度な画像処理や画像認識を実現できるようになった(1).更に,2014年,Goodfellowらは,新しい深層学習の形態であるGenerative Adversarial Networks(GAN:敵対的生成ネットワーク)を提案し,これにより自然な画像を人工的に生成できるようになった(2).GANは二つの深層ニューラルネットワークを互いに競わせて,自然な画像を生成する.この基本構成を図1に示す.GANは,基本的には,生成器(Generator)と識別器(Discriminator)からなり,これらは共に深層ニューラルネットワークである.GANは,雑音などの入力から,本物らしいデータを生成しようと学習し,識別器は,生成器が生み出した偽物データを本物データから区別しようと学習する.GANには多くの派生形があり,画像を入力して,それを別の見え方に変換するCycle GAN(3),pix2pix(4)などのGANも提案されている.

GANは,本物データとして集められた画像と類似する画像を生成することができるので,どのような画像を集めるかにより特性を設計できる.画像は,表示物体に関する客観的な情報を提供する一方で,「明るい感じ」「寂しい感じ」などの感性的な情報の提示をも行う.このような感性的な情報には言葉でうまく表現できないようなものもある.そこで,人の感性を反映した画像を集めて本物データとすることで,その感性を反映した画像を生成することができる.更に,GANに入力される雑音データを遺伝的アルゴリズムの染色体とみなし,対話形進化計算によって値を制御することにより,人の好みを反映させた画像を生成することができる.

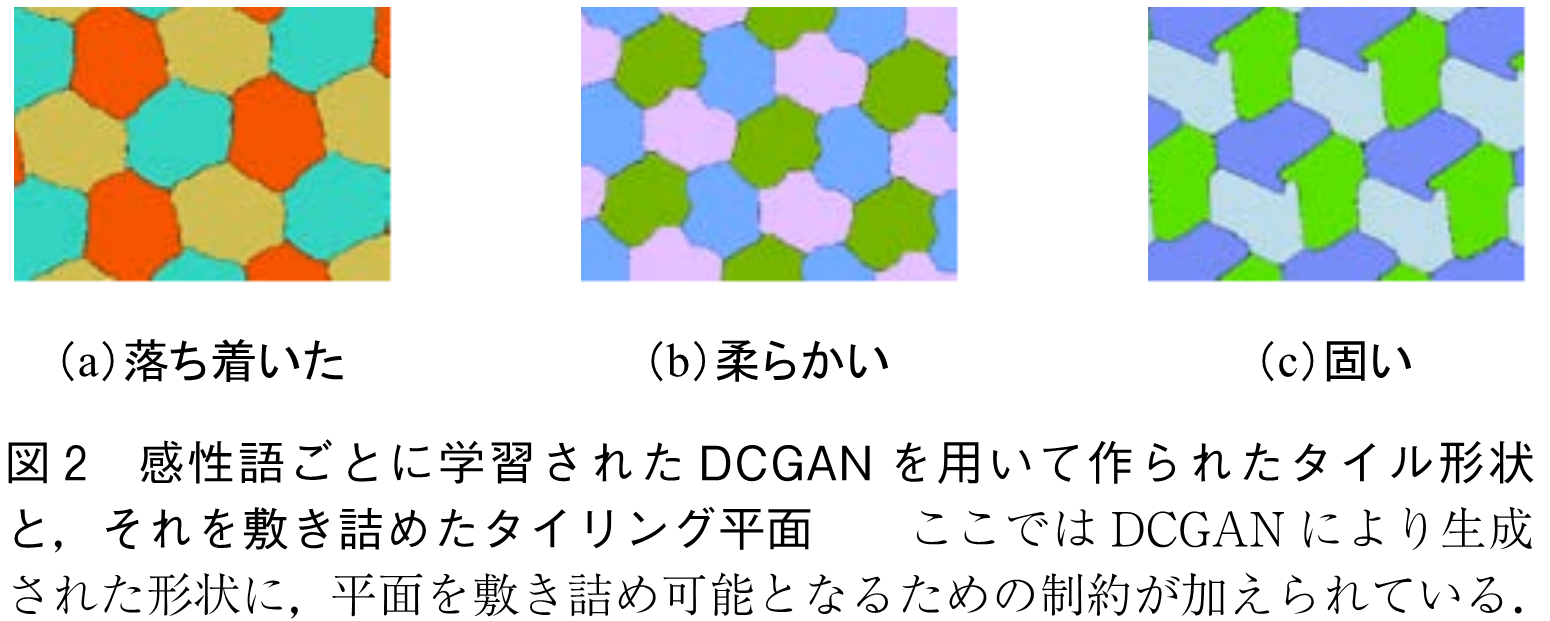

人の感性は言葉で表されることが多い.そこで,本物データとして,この感性語を反映した画像を集めGANを学習させることで,その感性語を反映した画像を生成することができる.佐川らは,家具画像・感性語のデータセットから転移学習を行い,「シンプル」「美しい」などの感性語をACGANに入力することにより,感性語を反映したロゴマーク画像の生成を行う方法を提案した(5).また,Takegishiらは,「柔らかい」「刺激的な」などの感性語を反映した形の生成をDCGANにより行い,それを基に,タイル形状をデザインする方式を提案した(6).図2に実際に生成されたタイリング平面の例を示す.

深層学習により画像の画風を他の画風に変換する方法が,2015年にGatysらにより提案された(7).このように,画像の画風(スタイル)を他のものに変換することをスタイル変換と呼ぶ.スタイル変換により,写真をそのコンテンツを変えずに自分の好みの画風,例えばゴッホの絵画風などに変換することが可能となる.Gatysらの方式は,畳込みニューラルネットワークを用いて実現され,出力画像が入力画像(コンテンツ画像)のコンテンツを含み,画風の採用元の画像(スタイル画像)と近い画風を持ち,更に滑らかな画像の体裁をなすように損失関数を設定して学習が行われる.

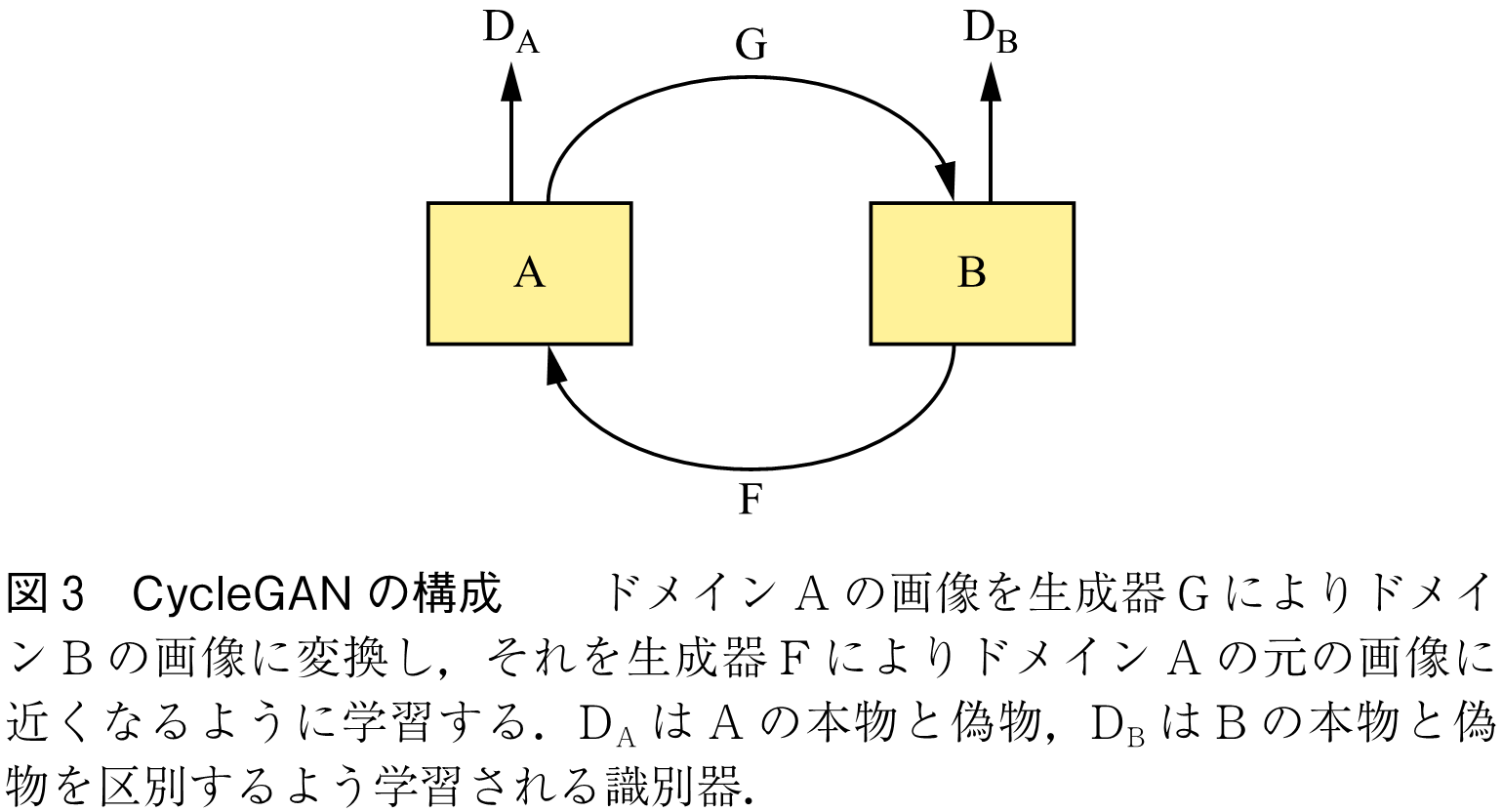

GANを用いてスタイル変換を行うこともできる.Zhuらが2017年に発表したCycle GANは,図3のように二つのタイプの画像の集合(ドメイン)間で画像のスタイル変換を行う(8).ここでは,ドメインAの画像を生成器GでドメインBの画像になるように変換し,それがまた生成器FでドメインAの元の画像に近付くように学習が行われる.この方式では,一方のドメインを写真,他方を好みの絵画とすると,写真をそのコンテンツを変えないで,好みの絵画風に変換することができる.

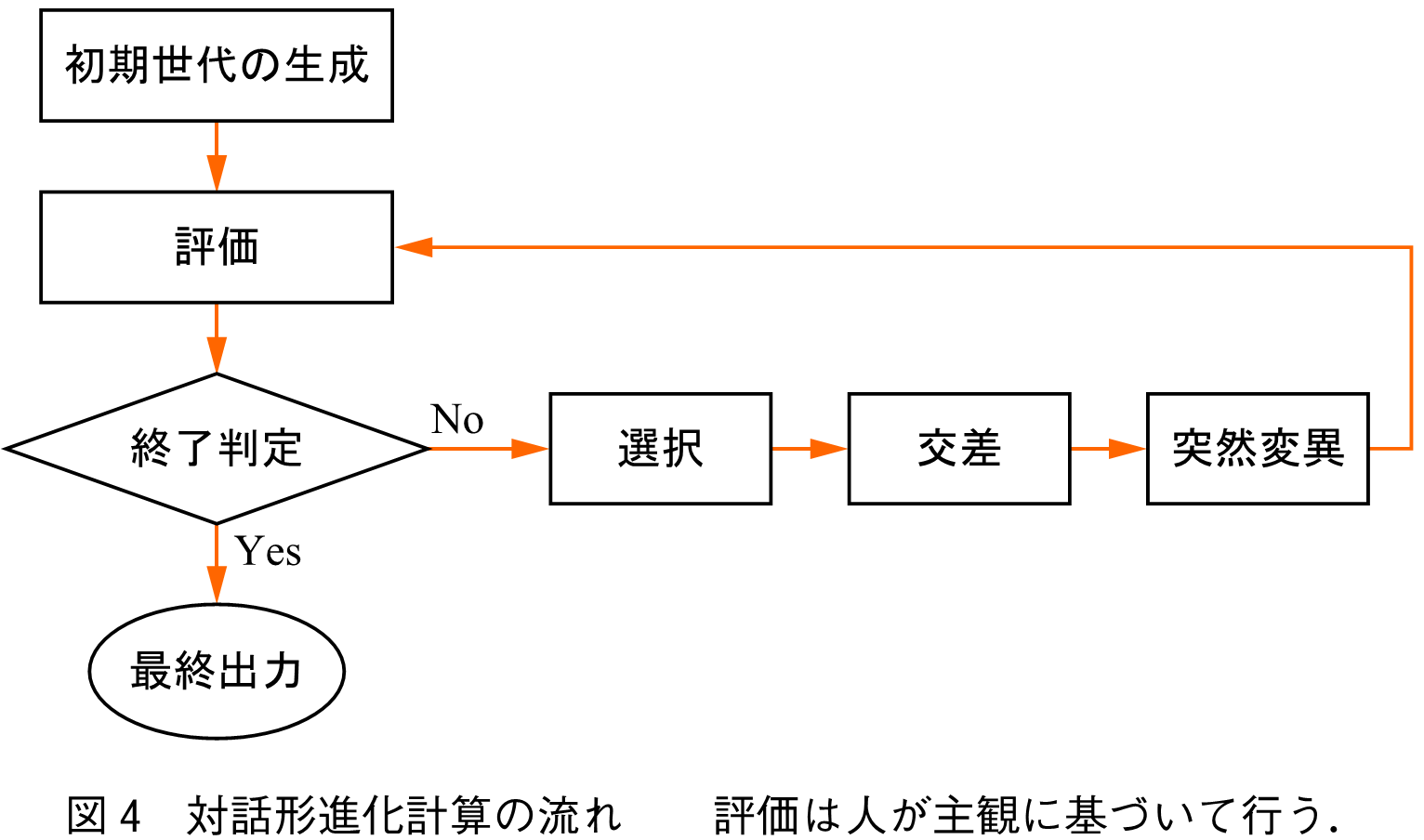

対話形進化計算は,システムを設計する際,このシステムパラメータを生物の染色体に見立て,遺伝的アルゴリズムなどの進化計算により最適化を行う(9).ここで,人の主観評価を用いてシステム出力の評価を行う.この構成図を図4に示す.すなわち,対話形進化計算は初期世代の個体(染色体)としてランダムな数値系列を複数個発生させ,これらの個体を使って画像などのデータを生成し,人がそれらを評価する.これらの生成物の中に,人が十分満足できるものがあればそれを選択して終了するが,そうでなければ,比較的評価の高い個体を何個か選ぶ(選択).次に,選択された個体と似ている個体と,似ていない個体を新たに生成し,これらと選択された個体を合わせて次世代の集団とする.ここで,選択された個体に似ている個体を作ることを交差,異なる個体を作ることを突然変異と呼ぶ.次世代においては,新しい個体を使ってデータを生成し,評価,選択,交差,突然変異を繰り返し,最終的に満足できるデータが得られれば終了する.

GANは,乱数列を潜在ベクトルとして用い,それに基づいて多様な画像を生成する.この潜在ベクトルは,生成される画像と関連付けられるが,特定の画像を生成するために乱数の値を制御することは行われない.そこで,この潜在ベクトルを対話形進化計算で扱われる染色体とみなすと,GANが生成するデータに対して対話形進化計算を適用することができる.これは,GANが生成する多数の画像等に対し,人が主観的に高く評価するものを探索していくことに相当する.

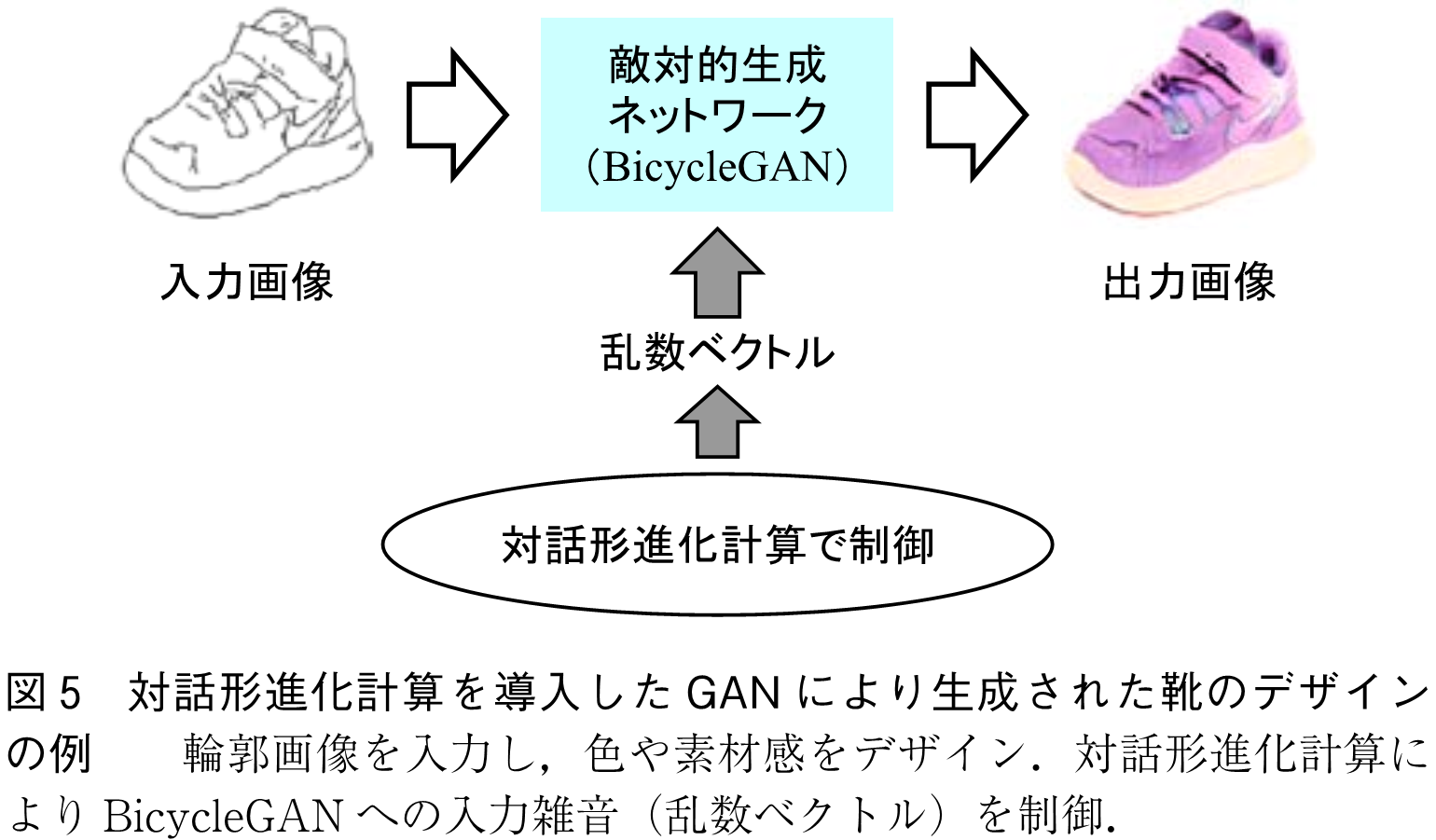

このように,対話形進化計算をGANに導入して潜在変数を制御する方法として,Bontragerは,DCGANに対話形進化計算を導入し,利用者の好みや主観評価を考慮した物体のデザインや顔画像の生成を実現できることを示した(10).しかし,一般的な物体のデザインは自由度が高く,DCGANでは所望のデザインが出現しづらい傾向がある.そこで,Xinらは,所望のデザインの輪郭画像を入力し,この輪郭の中身をGANと対話形進化計算の融合により生成する方式を提案した(11).ここでは,BicycleGAN(12)を用いる.BicycleGANはpix2pixのように,与えられた輪郭を有する画像を生成するGANであるが,乱数列を潜在変数として用いることで,画像に多様性を持たせることができる.図5はこの方式で実際に生成された靴のデザインの例を示したものである.

高精細な画像を生成するGANとして,低解像度画像から学習し,解像度を上げていくPGGANが2018年に発表されたが(13),これにスタイル変換を取り入れたのがStyleGANである(14).このStyleGANはランダムな潜在ベクトルを,スタイル情報を表す潜在空間に変換し,それを解像度ごとに深層ニューラルネットワークの各畳込み層に入れ込む.この潜在空間におけるベクトルもランダムな数値系列として表されるので,複数の生成画像の潜在空間を同じ解像度同士で混ぜたり入れ替えたりすることで,画像のスタイルを考慮しながら交差を実現することができる.Tejeda-Ocampoらは,このような解像度ごとの潜在空間の統合を行う対話形進化計算により,絵画を効果的に生成する方法を提案した(15).また,Liaoらは,潜在空間の低・中・高の解像度領域が,映画ポスターのタイトル,人物の構成,全体の色味のスタイルに対応することを明らかにし,解像度ごとの潜在空間の入替えを行うことで利用者の好みの映画ポスターのレイアウトを生成する方式を提案した(16).

AI,特に深層学習の躍進により,人が本物の写真や絵画とみなすような画像をコンピュータ上で生成することができるようになった.また,人が,好ましいと思う画像そのものを入力したり,その画風を言葉で表して入力することで,AIは人の感性とそれを反映した画像の間をつなぐ数理モデルを実現し,人の感性を考慮した画像生成が可能となった.今後もAIが,人の精神的側面を更に充実させることが期待される.

(1) A. Krizhevsky, I. Sutskever, and G.E. Hinton, “Imagenet classification with deep convolutional neural net-works,” Advances in Neural Information Processing Systems 25, pp.1097-1105, 2012.

(2) I. Goodfellow, J. Pouget-Abadie, M. Mirza, B. Xu, D. Warde-Farley, S. Ozair, A. Courville, and Y. Bengio, “Generative adversarial nets,” Advances in Neural Information Processing Systems 27, 2014.

(3) J-Y. Zhu, T. Park, P. Isola, and A.A. Efros, “Unpaired Image-to-Image translation using cycle-consistent adversarial networks,” arXiv: 1703. 10593[cs. CV], 2017.

(4) P. Isola, J-Y. Zhu, T. Zhou, and A.A. Efros, “Image-to-image translation with conditional adversarial networks,” arXiv: 1611.07004[cs. CV], 2017.

(5) 佐川友里香,萩原将文,“感性語を考慮した敵対的生成ネットワークを用いたロゴマーク生成,”日本感性工学会論文誌,vol.18, no.3, pp.215-222, 2019.

(6) M. Takegishi and K. Arakawa, “Interactive evolutionary design method of tile shape by GAN reflecting adjectives,” 2021 ISPACS, Nov. 2021. DOI: 10.1109/ISPACS51563.2021.9651018

(7) L.A. Gatys, A.S. Ecker, and M. Bethge, “A neural algorithm of artistic style,” arXiv: 1508.06576[cs. CV], Aug. 2015.

(8) J.Y. Zhu, T. Park, P. Isola, and A.A. Efros, “Unpaired image-to-image translation using cycle-consistent adversarial networks,” Proc. IEEE Int. Conf. Computer Vision (ICCV) 2017, pp.2223-2232, 2017.

(9) H. Takagi, “Interactive evolutionary computation : fusion of the capabilities of EC optimization and human evaluation,” Proc. IEEE, vol.89, pp.1275-1296, 2001.

(10) P. Bontrager, et al., Deep interactive evolution Int. Conf. Computational Intelligence in Music, Sound, Art and Design, Springer, Cham, 2018.

(11) C. Xin and K. Arakawa, “Object design system by interactive evolutionary computation using GAN with contour images,” KES-HCIS 2021, Smart Innovation, Systems and Technologies, vol 244. Springer, Singapore, 2021.

https://doi.org/10.1007/978-981-16-3264-8_7

(12) J. Zhu, et al., “Toward multimodal image-to-image translation,” Advances in neural information processing systems, 2017.

(13) T. Karras, T. Aila, S. Laine, and J. Lehtinen, “Progressive growing of GANs for improved quality, stability, and variation,” arXiv: 1710.10196[cs. NE].

(14) T. Karras, S. Laine, and T. Aila, “A style-based generator architecture for generative adversarial networks,” arXiv: 1812.04948[cs. NE].

(15) C.T. Ocampo, et al., “Improring deep interactive evolution with a stylebased generator for artistic expression and creative exploration,” Entropy, 23, 11, 2020.

https://doi.org/10.3390/e23010011

(16) S. Liao and K. Arakawa, “Interactive poster design system for movies with StyleGAN,” 2021 Int. Symp. Intelligent Signal Processing and Communication Systems (ISPACS), pp.1-2, doi: 10.1109/ISPACS 51563.2021.9651023, Hualien City, Taiwan, 2021.

(2023年10月19日受付)

オープンアクセス以外の記事を読みたい方は、以下のリンクより電子情報通信学会の学会誌の購読もしくは学会に入会登録することで読めるようになります。 また、会員になると豊富な豪華特典が付いてきます。

電子情報通信学会 - IEICE会誌はモバイルでお読みいただけます。

電子情報通信学会 - IEICE会誌アプリをダウンロード